OS ALGORITMOS SÃO RACISTAS?

#blogpost #inteligência artificial #racismo algorítmico

Tecnologias podem ser racistas, discriminar e reforçar assimetrias de poder ou servir de ferramenta para superação de desigualdades

Por Erly Guedes*

Os algoritmos, que fuçam nossos dados e nos enquadram em identidades digitais, são atravessados por juízos de valor criados em sociedade. São como espelhos que podem refletir as visões de mundo de seus desenvolvedores e certos preconceitos (que chamamos de bias ou vieses) podem influenciar o comportamento dos sistemas.

Projetados, desenvolvidos e implantados principalmente por e para homens cis, brancos e heterossexuais no Norte Global, os algoritmos podem fornecer ferramentas para amplificar diferentes formas de discriminação contra pessoas negras. De altas taxas de imprecisão de reconhecimento facial a práticas discriminatórias de contratação de mulheres negras, são inúmeras as maneiras pelas quais a Inteligência Artificial pode discriminar pessoas e grupos de forma racista.

No cenário atual do “capitalismo de vigilância”, nossos movimentos, gostos, pensamentos, sentimentos e relações são registrados e transformados em dados — informações exploradas economicamente — por meio de cada clique, busca, curtida ou compartilhamento de conteúdo na web ou mesmo por meio de informações coletadas pelos mais diversos apps ou serviços.

Em uma sociedade que nunca resolveu sua história colonial, ferramentas de IA constrõem padrões racistas a partir dos dados coletados — uma fonte continuamente recarregada por toda forma de dados pessoais, levando à digitalização massiva dos ambientes em que vivemos, dos nossos corpos e dos nossos hábitos.

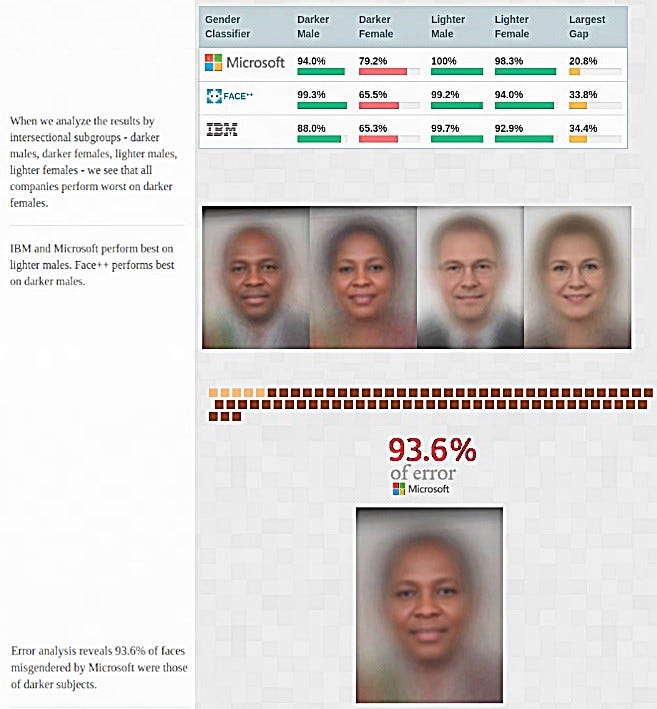

Há muita gente criativa produzindo conteúdo sobre essas questões e movendo as estruturas. Algumas delas têm bastante visibilidade no Norte Global, como a pesquisadora do MIT, Joy Buolamwini, que se dedicou a desvendar o viés de gênero e raça em diferentes sistemas de reconhecimento facial em sua tese de doutorado, o projeto Gender Shades. Os resultados de sua pesquisa, na qual analisou as ferramentas de reconhecimento facial das gigantes da tecnologia Microsoft, Facebook e IBM, foram estarrecedores: todos os sistemas apresentaram um desempenho melhor em rostos de homens do que em rostos de mulheres, além de todos eles serem mais eficientes em rostos de pele mais clara do que em rostos de pele mais escura. Foram muito altas as taxas de erro para identificar imagens de mulheres negras, chegando a 35% para mulheres de pele mais escura; já para homens brancos a taxa de erro foi mínima (1%).

Neste Dia da Consciência Negra, criado para afirmar a humanidade e celebrar a vida de pessoas negras, aproveitamos a data para compartilhar neste artigo o trabalho de algumas pessoas aqui do Brasil que também estão desvelando e lutando coletivamente contra o racismo embrenhado nas tecnologias, seus códigos e ambientes.

KilomboTech

É um hub de inovação tech que busca construir um futuro com protagonismo das mulheres negras na tecnologia, criado por Bárbara Aguilar (@bahlutz) e Allana Cardoso (@aallanacardoso). Com o objetivo de ser uma ponte entre mulheres negras e o mercado de tecnologia, a partir de uma perspectiva afrofuturista a Kilombo Tech apoia a criação de novas narrativas sobre vidas constantemente atravessadas por violências raciais. “Quebrar paradigmas de uma sociedade estruturalmente racista e machista parece algo distante, mas optamos por agir em favor desta mudança”, afirmam suas criadoras.

Laboratório de Identidade Digitais e Diversidade da Escola de Comunicação da UFRJ — LIDD/UFRJ

Coordenado pela professora Fernanda Carrera (@nandacarrera), o Laboratório de Identidades Digitais e Diversidade da Escola de Comunicação da UFRJ pesquisa algoritmos e seus impactos sociais como racismo, machismo, classismo e outros. Recentemente, o LIDD produziu uma série de webinários chamado Comunicação, Raça e Interseccionalidades. Além disso, sua coordenadora Fernanda Carrera publicou o artigo “Racismo e Sexismo em Bancos de Imagens Digitais: análise de resultados de busca e atribuição de relevância na dimensão financeira/profissional” no livro Comunidades, Algoritmos e Ativismos Digitais: olhares afrodiaspóricos, no qual apresenta os resultados de pesquisa sobre representações na entrega de imagens em bancos de imagens como Shutterstock, Stockphoto e Getty Images.

Rede de Ciberativistas Negras

A Rede nasceu em 2017, durante um encontro do projeto “Mulheres Negras Fortalecendo na Luta Contra o Racismo e Sexismo”, e logo se tornou uma ferramenta forte e segura para o fortalecimento das mulheres negras que desenvolvem online o combate ao racismo, ao sexismo e a outras formas de opressão.

PretaLab

Outro coletivo que busca incluir mais mulheres negras na inovação e tecnologia é o PretaLab, criado pela Sil Bahia. A ideia é ter acesso a ferramentas tecnológicas para criar futuros possíveis — desmantelando o sistema racista, heteronormativo e patriarcal.

Ogunhê

É o podcast criado pela hacker antirracista e cientista da computação Nina Da Hora. Lá ela compartilha e apresenta cientistas do continente africano e suas contribuições científicas que ajudam a sociedade. Ogunhê é a saudação ao orixá Ogum, que nas religiões de matriz africana é o orixá da Tecnologia, Guerra e Agricultura. Para sobreviver, Ogum criava suas próprias armas (tecnologias) e muitos outros objetos para tranformar tudo ao seu redor. Uma ótima metáfora para a luta contra o epistemicídio, isto é, a anulação de pessoas negras como sujeitos de conhecimento, por meio da desvalorização, negação ou ocultamento das contribuições do continente africano e da diáspora africana à humanidade.

Computação da Hora

Dose dupla da Nina Da Hora! No Computação da Hora, a hacker antirracista descomplica tecnologias e conceitos da computação com uma linguagem acessível e de um jeito divertido! Nina também pretende com o projeto mostrar a importância da participação de mulheres, especialmente negras, no desenvolvimento de tecnologias.

Geledés — Instituto da Mulher Negra

É uma organização da sociedade civil que combate a desigualdade racial e de gênero desde 1988. Dentre seus vários projetos, o Portal Geledés é um grande espaço de expressão de pesquisadores, parceires e das ações que o próprio instituto desenvolve. O site foi criado em 2009 como ferramenta tecnológica para articulação política e construção de redes de solidariedade.

TecnoHype

Mais um podcast na nossa listinha! Co-apresentado pelo Lucas Santana, o TecnoHype descortina as tecnologias e como elas impactam a sociedade e nossos comportamentos — tudo numa linguagem bacana e acessível para quem não é especialista ou entusiasta da área.

O Panóptico

Disponível no Twitter e no Instagram, a iniciativa monitora os projetos de Reconhecimento Facial no Brasil e identifica violações de direitos, erros e vieses derivados do uso dessa tecnologia. Além do mapeamento, feito por meio de documentos governamentais, matérias jornalísticas e relatórios de organizações, O Panóptico analisa os efeitos do uso dessa ferramenta de IA nas abordagens, apreensões e prisões feitas pela polícia.

Thiane Neves

Professora, integrante da Coletiva Periféricas SSA e do Grupo de Pesquisa em Gênero, Tecnologias Digitais e Cultura — Gig@ da Universidade Federal da Bahia, Thiane Neves se define como afro-amazônica que vive a comunicação para a diversidade negra, feminista e periférica. Escreve para o Blogueiras Negras e pesquisa sobre ciberfeminismo negro. Publicou recentemente o capítulo “Estamos em Marcha! Escrevivendo, Agindo e Quebrando Códigos” no livro Comunidades, Algoritmos e Ativismos Digitais: olhares afrodiaspóricos, no qual reflete sobre o ciberfeminismo a partir de chaves teóricas como a amefricanidade de Lélia Gonzalez.

Tarcízio Silva

A tecnologia não é neutra e a gente sabe bem disso. O pesquisador Tarcízio Silva mostra na sua tese de doutorado “Dados, Algoritmos e Racialização em Plataformas Digitais” como o racismo está imbricado nos algoritmos de mídias sociais, apps e Inteligência Artificial. Por meio de uma linha do tempo, ele facilita a visualização dos danos algorítmicos encontrados na pesquisa. Recentemente publicou o livro Comunidades, Algoritmos e Ativismos digitais: olhares afrodiaspóricos no qual reúne 14 artigos de pesquisadoras e pesquisadores do Brasil e de países da Afrodiáspora e África, como Congo, Etiópia, Gana, Nigéria, Colômbia, Estados Unidos e Reino Unido.

Lembrou de mais projetos ou iniciativas que estão hackeando estruturas racistas? Conta pra gente!

*Erly é assessora de comunicação na Coding Rights e mestranda no Programa de Pós-Graduação em Comunicação da Universidade Federal Fluminense, no qual estuda narrativas identitárias de mulheres negras no Facebook. Tem sua pesquisa atravessada por questões de gênero, raça e corpo na contemporaneidade. Nutre profundo interesse por assuntos de beleza, identidades, representações, mídias sociais, algoritmos, mulheres e feminismo negro. É bolsista FAPERJ Nota 10 e integra o Núcleo de Estudos em Comunicação de Massa e Consumo — NEMACS.

Mais sobre o tema:

https://lavits.org/wp-content/uploads/2019/12/Silva-2019-LAVITSS.pdf

https://www.nytimes.com/2018/02/09/technology/facial-recognition-race-artificial-intelligence.html

https://cesecseguranca.com.br/projeto/o-panoptico-monitor-do-reconhecimento-facial-no-brasil