Reconhecimento facial: 10 anos de resistências e parcerias criativas para trazer o tema para o debate público

#blogpost #democracia #inteligência artificial #reconhecimento facialUma tecnologia que está, literalmente, na cara do povo e cada vez mais na pauta do dia — o que também traz perigos, apontados há mais de uma década por pesquisadores e movimentos sociais

Mesmo que você não seja uma pessoa super por dentro do mundo das tecnologias, provavelmente já viu alguma polêmica envolvendo “reconhecimento facial” nos últimos tempos. Seja porque o pessoal no Twitter estava debatendo se deve ou não usar reconhecimento facial pra desbloquear app de banco, ou quem sabe porque o filtro do tiktok não tá funcionando direito no seu rosto. Ou até porque viu no jornal alguém preso injustamente pelo uso dessa tecnologia em câmeras de segurança.

Nos últimos anos, reconhecimento facial foi muito rápido de papo meio futurista pra algo comum na vida das pessoas. E o problema dessa normalização meio à jato é que essa, como tantas outras, é uma tecnologia sujeita a enviesamentos de quem a desenvolve, e está sendo usada pra coisas muito delicadas. Tipo na prisão de pessoas.

Há pelo menos uma década tem gente denunciando os perigos do reconhecimento facial na “segurança pública”, e aqui nós vamos reunir algumas iniciativas que promovemos ou impulsionamos pra resistir e inspirar o debate nos últimos anos.

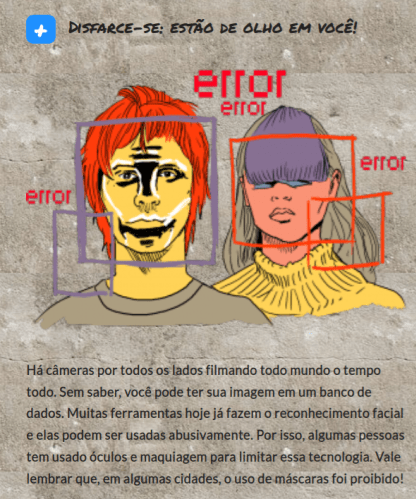

Em 2014, ano em que o país tinha acabado de viver os grandes protestos de 2013, antes mesmo da Coding existir (nascemos em 2015), a Joana Varon, nossa diretora-executiva, já estava observando o tema e lançou, em parceria com a Artigo 19, o guia ilustrado protestos.org, que trazia dicas de cuidados digitais no contexto das manifestações e, entre várias dicas, alertava sobre a iminência do uso do reconhecimento facial nas câmeras de rua, e como essa tecnologia poderia ser utilizada para aumentar violência policial e repressão, ameaçando o direito de protesto. Já faz tempo, mas o alerta infelizmente ainda é bem atual.

A pesquisa Gender Shades, publicada em 2018, pela Joy Buolamwini, junto com a Timnit Gebru, é uma referência pioneira para entender viéses de raça e gênero nas tecnologias de reconhecimento facial, pois provou como sistemas de reconhecimento facial apresentam mais falhas quando aplicados em rostos de mulheres negras, funcionando melhor com homens cis brancos. Com este estudo, Joy e Timnit trouxeram o que o pesquisador brasileiro Tarcízio Silva cunhou de “racismo algorítmico” para o centro das pesquisas sobre reconhecimento facial, que até então tinham um foco mais restrito na vigilância em massa. A repercussão foi tanta que logo depois Joy fundou a Algorithmic Justice League, uma organização que faz até auditoria de algoritmos para pesquisar as ameaças dessas e outras tecnologias de inteligência artificial, em especial para pessoas negras.

Em 2019, a Joana teve o privilégio de entrevistar a Joy no MIT, em Cambridge. O vídeo foi base do primeiro episódio do webdocumentário Das Telas aos Corpos, ou From Devices to Bodies na versão em inglês. Numa das cenas do doc, recuperamos uma participação da Joy no congresso americano, sendo questionada pela Alexandria Ocasio-Cortez, em uma sessão sobre os perigos da tecnologia de reconhecimento facial. Uma conversa imperdível.

A gente ainda entrevista no doc a Mariah Rafaela Silva, pesquisadora e ativista trans, e a cientista da computação Nina Da Hora, pra contextualizar o debate no Brasil.

Ainda em 2020, a Mariah e a Joana lançaram a pesquisa Reconhecimento Facial no Setor Público – tecnopolíticas de controle e ameaça à diversidade de gênero em suas interseccionalidades de raça, classe e território. Um projeto bem importante para situar quem é visível e quem é invisível no desenvolvimento e uso dessas estruturas e para falar sobre os perigos dessa tecnologia para a população trans no Brasil.

Na pesquisa, foram reunidas também percepções de ativistas trans e dados sobre o uso do reconhecimento facial para acesso a serviços públicos, tipo o gov.br e para a Carteira Nacional de Habilitação.

Mesmo com webdoc, pesquisa, entrevista e tudo mais, a gente ainda queria falar mais sobre. E trazer gente diferente pro papo. Foi aí que resolvemos chamar a própria Dona Algô, a algoritma do reconhecimento facial, pra um podcast sobre o tema. A Dona Algô é uma personagem criada pela influenciadora Malfeitona, e nos ajudou a apresentar de forma bem humorada os erros do reconhecimento facial. No episódio, a Bianca Kremer e a Vanessa Koetz entrevistaram a Mariah Rafaela, acadêmica e ativista em direitos da população trans e Pablo Nunes, estudioso negro, ativista e especialista em segurança pública e racismo.

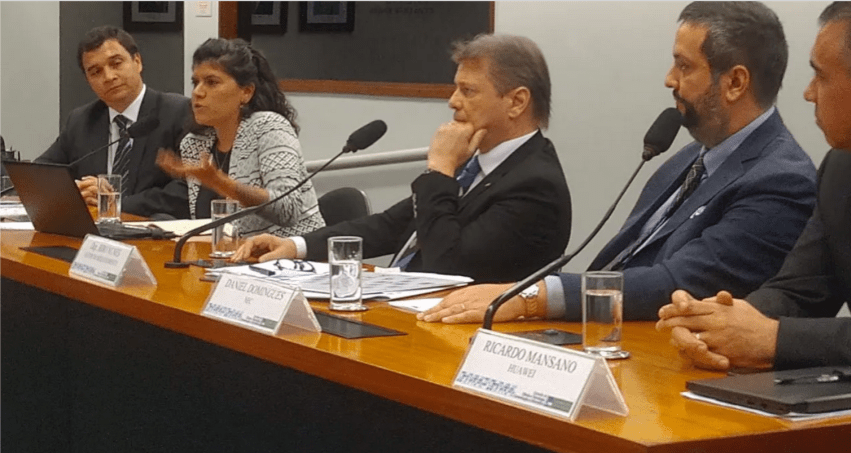

Em meio a tanta pesquisa e tentativas de traduzir o assunto para um público mais amplo, também tivemos em arenas de incidência política mais direta. Em 2019, a Joana Varon participou de uma audiência pública promovida pela Comissão de Ciência, Tecnologia, Comunicação e Informática da Câmara dos Deputados sobre reconhecimento facial, proposta pelo deputado Bibo Nunes. Uma mesa bem pouco diversa e com muitas pessoas que defendiam os interesses da indústria. A serviço de quem pode ser uma regulação pensada em um espaço assim?

Felizmente, uns anos depois, outras iniciativas, com atores mais diversos e críticos, começaram a surgir no legislativo. Em 2022, ajudamos a impulsionar a campanha “Sai da Minha Cara”, uma articulação com mais de 50 parlamentares que apresentaram projetos de lei pelo banimento do reconhecimento facial em espaços públicos, em diálogo com organizações da sociedade civil e pesquisadores, como Coding Rights, MediaLab-UFRJ/Rede Lavits, Instituto Brasileiro de Defesa do Consumidor (Idec) e Centro de Estudos de Segurança e Cidadania — (CESeC).

E também construímos, junto com as organizações da Coalizão Direitos na Rede e muitas outras, a campanha Tire Meu Rosto da Sua Mira, outra iniciativa importante para abrir caminhos para o debate em diferentes espaços de formulação de políticas e mobilização, em diálogo também com movimentos sociais. Uma perspectiva bem mais promissora do que uns anos atrás…

Um momento importante nesse processo foi a decisão do Tribunal de Justiça do Estado de São Paulo de suspender liminarmente o pregão do projeto Smart Sampa, depois de representação apresentada pela Coding em conjunto com outras entidades da Campanha Tire Meu Rosto da Sua Mira ao Tribunal de Contas do Município de São Paulo. O edital da Smart Sampa previa a contratação de equipamentos eletrônicos e a implementação de mais de 20 mil câmeras de reconhecimento facial na capital paulista até 2024. Depois o pregão acabou acontecendo, contemplando uma empresa cheeeia de polêmicas, como a gente ajudou a contar em uma reportagem da série “Quem Paga a Conta?”, em parceria com o The Intercept Brasil e CESeC. Essa série aponta a falta de transparência nos investimentos públicos na implementação de tecnologias de reconhecimento facial. As matérias denunciam desde empresas americanas fazendo reuniões secretas com órgãos federais de segurança para oferecer fotos de brasileiros e brasileiras até contratos milionários de câmeras com tecnologias de reconhecimento facial em cidades muito pequenas onde sequer a prefeitura sabia que o projeto existia.

Levando em conta todo esse acúmulo sobre o tema e o avanço da implementação das tecnologias de reconhecimento facial pelo poder público no país, o mandato da deputada estadual Dani Monteiro (PSOL), organizou, em agosto deste ano, junto à campanha Tire Meu Rosto da Sua Mira, da qual fazemos parte, o seminário “Reconhecimento Facial no Rio de Janeiro: Diálogos e Resistências”. O evento reuniu organizações que debatem o tema no território fluminense com o objetivo de ampliar o debate com parlamentares estaduais e municipais, e contou com a presença da Joana Varon em uma das mesas trazendo um panorama histórico do debate. Estiveram presentes, além de deputadas da ALERJ, vereadoras dos municípios de Niterói e Rio de Janeiro. Uma iniciativa fundamental entre a sociedade civil e o poder público para que o poder público não utilize esse tipo de tecnologia sem que haja uma ampla discussão com a sociedade sobre suas implicações à vida da população.

E o debate não pode parar por aí. Reconhecimento facial é uma das primeiras tecnologias de inteligência artificial a ser utilizada de forma massiva pelo poder público, no Brasil e em vários outros países. Mas isso não quer dizer que seja a única. Em 2021 nós lançamos um projeto com a pesquisadora Paz Peña chamado Que Inteligência?. A ideia era mapear e analisar projetos de Inteligência Artificial implementados pelo setor público na América Latina. Descobrimos que reconhecimento facial representa uma primeira onda de implementação de IA com riscos sérios de automatizar uma série de opressões históricas, mas policiamento preditivo, e outros projetos de IA usados em áreas como distribuição de benefícios sociais, educação, saúde — sobretudo direcionados para populações mais vulnerabilizadas já estão em fase piloto, representando grandes ameaças na garantia de direitos fundamentais.

A gente espera que toda essa retrospectiva ajude de alguma forma a inspirar resistências a tecnologias que vão sendo implementadas acriticamente pelo poder público, aumentando violências contra corpos e grupos que justamente deveriam estar sendo acolhidos. E que a gente possa seguir imaginando outras possibilidades de futuros, com criatividade e coletividade.